Индексация сайта

Содержание:

- Как часто происходит индексация?

- Что значит «индексация»

- Два пути индексации сайта

- Robots.txt

- Как проверить индексацию

- Основания для перерасчета

- Что такое индексация обратных ссылок

- Как запретить индексацию сайта или отдельной страницы

- Документальное оформление индексации

- Ошибки индексации

- Используем панель Вебмастера

- Как ускорить индексацию сайта в поисковых системах

Как часто происходит индексация?

Индексация сайта в зависимости от ряда причин может занимать от нескольких часов до нескольких недель, вплоть до целого месяца. Обновление индексации, или апы поисковых систем происходят с различной периодичностью. По статистике в среднем Яндекс индексирует новые страницы и сайты за период от 1 до 4 недель, а Google справляется за период до 7 дней.

Но при правильной предварительной подготовке созданного ресурса эти сроки можно сократить до минимума. Ведь по сути все алгоритмы индексации ПС и логика их работы сводится к тому, чтобы дать наиболее точный и актуальный ответ на запрос пользователя. Соответственно, чем регулярнее на вашем ресурсе будет появляться качественный контент, тем быстрее он будет проходить индексацию.

Что значит «индексация»

Лучше, чем спец Яндекса по индексации, вам об этом не расскажет никто:

Индексация — это процесс, в ходе которого страницы сайта обходит поисковый робот и включает (либо же не включает) эти страницы в индекс поисковой системы. Поисковый бот сканирует весь контент, проводит семантический анализ текстового содержимого, качество ссылок, аудио- и видеофайлов. На основе всего этого поисковик делает выводы и вносит сайт в ранжирование.

Пока сайт вне индекса, о нем никто не узнает, кроме тех, кому вы можете раздать прямые ссылки. То есть ресурс доступен для просмотра, но в поисковой системе его нет.

Два пути индексации сайта

Есть два пути, с помощью которых поисковая система узнает о новом ресурсе и начнется индексация сайта:

1

Для того чтобы сообщить поисковикам о новом ресурсе, нужно обязательно воспользоваться специальными сервисами для веб мастеров:

- Яндекс.Вебмастер (https://webmaster.yandex.ru/),

- Google Webmaster Tools (//www.google.com/webmasters/tools/),

- Webmaster.mail (https://webmaster.mail.ru/),

- Bing Webmaster Tools (https://www.bing.com/toolbox/webmaster),

- Nigma.ru.

2

Этот вариант рекомендован к использованию в большинстве случаев: просто получите некоторое количество внешних ссылок на ресурс и дожидайтесь прихода робота. Добавление сайта вручную в некоторых случаях даже удлиняет срок ожидания робота.

Как правило, первичная индексация сайта занимает от 2-3 дней до двух недель и это зависит от системы поиска.

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Как проверить индексацию

Проверка видимости документов html осуществляется по-разному для Google и Яндекс. Но в целом не представляет собой ничего сложного. Сделать это сможет даже новичок.

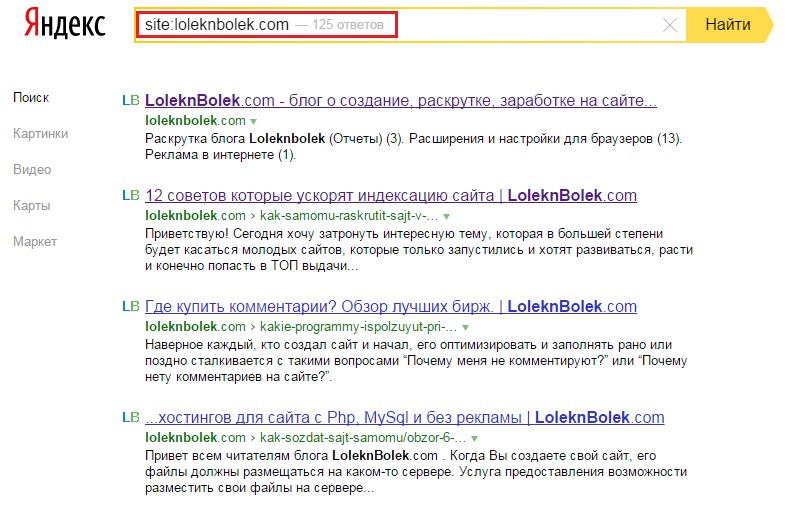

Проверка в Яндекс

Система предлагает три основных оператора, позволяющих проверить, сколько html-документов находится в индексе.

Оператор «site:» – показывает абсолютно все страницы ресурса, которые уже попали в базу данных.

Вводится в строку поиска следующим образом: site:znet.ru

Оператор «host:» – позволяет увидеть проиндексированные страницы с доменов и поддоменов в рамках хостинга.

Вводится в строку поиска следующим образом: host:znet.ru

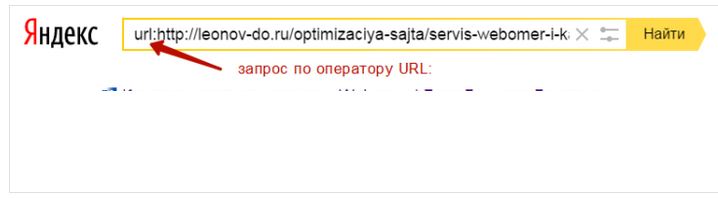

Оператор «url:» – показывает конкретную запрашиваемую страницу.

Вводится в строку поиска следующим образом: url:znet.ru/obo-mne

Проверка индексации этими командами всегда дает точные результаты и является самым простым способом анализа видимости ресурса.

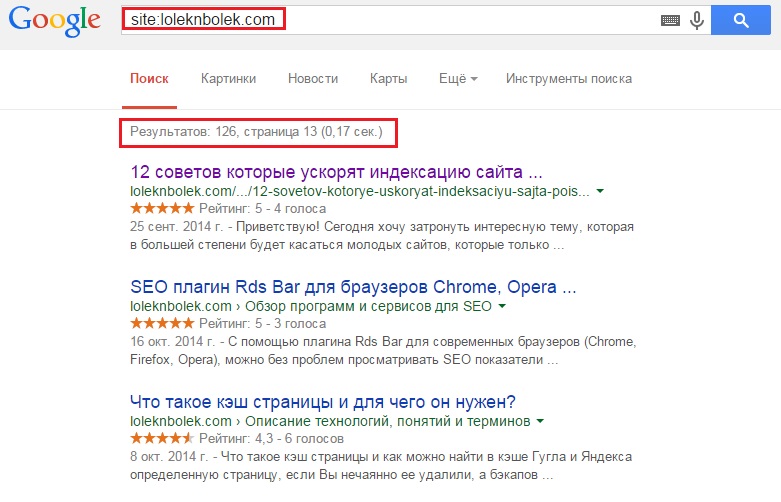

Проверка в Google

ПС Гугл позволяет проверить видимость сайта только по одной команде вида site:znet.ru.

Но у Google есть одна особенность: он по-разному обрабатывает команду с введенными www и без. Яндекс же такого различия не делает и дает абсолютно одинаковые результаты, что с прописанными www, что без них.

Проверка операторами — это самый «дедовский» способ, но я для этих целей пользуюсь плагином для браузера RDS Bar.

Проверка с помощью Webmaster

В сервисах Google Webmaster и Yandex Webmaster также можно посмотреть, сколько страниц находится в базе данных ПС. Для этого нужно быть зарегистрированным в этих системах и внести в них свой сайт. Попасть в них можно по ссылкам:

http://webmaster.yandex.ru/ — для Яндекс.

https://www.google.com/webmasters/ — для Google.

В Яндекс Вебмастере при нажатии на ссылку «Мои сайты» в левом боковом меню появятся все необходимые пункты для проверки не только количества страниц, но и многих других полезных и важных данных, в том числе и истории индексации.

Массовая проверка страниц на индексацию

Если вы ведете файл семантики по моей схеме, то проверить все страницы на индексацию для вас — дело трех минут.

- Заходим в файл распределения

- Выделяем все урлы в столбце URL

- Вкладка «Данные» — «Удалить дубликаты», таким образом останется список всех продвигаемых страниц

- Массово проверяем страницы на индексацию через Comparser. Можно и с помощью браузерного плагина Winka – он умеет работать со списком ссылок в отрыве от Сапы (вызвать меню плагина – проверка списка ссылок).

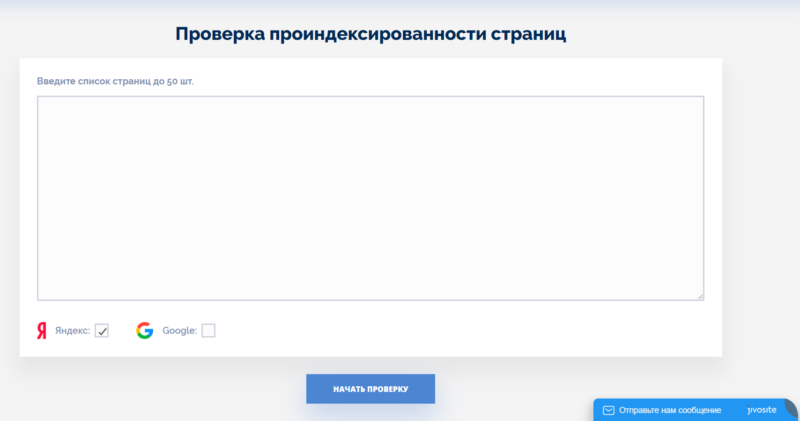

Сервисы вроде Serphunt

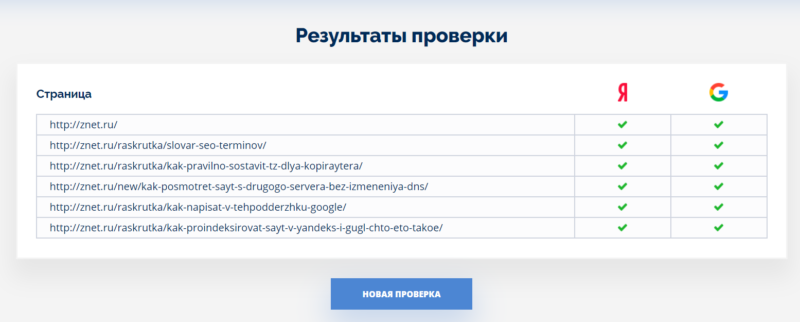

Сейчас я проверяю индексацию в основном здесь: https://serphunt.ru/indexing/, потому что у них можно сразу 50 урлов проверить и причем не только в яндексе, но и в гугле. Мало где можно проверить одновременно в обеих ПС на халяву сразу 50 урлов.

Суть такая — просто вбиваете адреса страниц, и сервис вам выдаёт результаты:

Проверяет не очень быстро — там надо будет подождать минуты 3, но к бесплатному инструменту и претензий немного. Просто в фоновом окне ставьте и занимайтесь своими делами, через несколько минут результаты будут готовы.

Основания для перерасчета

Несмотря на то, что в качестве одной их мер приблизить уровень реального содержания зарплаты в связи с инфляцией законодатель в ст. 134 ТК РФ указывает индексацию, это не значит, что повышение цен служит показателем для перерасчета заработка.

Четко обозначенного механизма, периодичности и порядка проведения процедуры индексации не существует. Принимать решение о необходимости индексации выплат собственники и уполномоченные ими руководить деятельностью предприятий и организаций вправе на свое усмотрение, утвердив данные нормы локальными правовыми актами внутреннего пользования.

За основания проведения индексации можно, но не обязательно принимать соответствующие публикации Росстата. Как показывает практика судебных разбирательств по обращению граждан с исками о защите гарантированных трудовых прав, эти показатели должны расцениваться как повод для увеличения уровня выплат.

Правом работодателя остается, в качестве условия индексации заработной платы, руководствоваться данными увеличения цен:

- по всей стране;

- в регионе местонахождения предприятия, выступающего юридическим лицом или фактической деятельности предпринимателя, использующего труд наемных рабочих;

- ростом прожиточного минимума трудоспособной части населения.

Согласно подготовленной специалистами КонсультантПлюс, величина прожиточного минимума на душу населения на I квартал 2021 года в марте текущего года по стране не установлена. За базовый ориентир принимают прошлогодние показатели III квартала 2019 года:

Что такое индексация обратных ссылок

Индексация обратных ссылок — процесс добавления их в базу поисковых систем. Когда роботы Яндекса и Гугла обнаруживают новый контент, они сканируют его и через некоторое время страница появляется в выдаче.

Несколько лет назад поисковики индексировали контент гораздо медленнее, чем сейчас. Особенно ярко выраженной проблема была в Яндексе. Вебмастера неделями ждали апдейтов, чтобы новые страницы попали в базу поисковой системы и начали набирать вес.

В 2021 году таких проблем нет — если сайт хорошо оптимизирован по технической части и регулярно публикует контент, новые адреса быстро попадают сначала в быструю выдачу, а затем в основную.

С бэклинками не все так просто — они индексируются гораздо дольше. При покупке ссылок напрямую есть риск остаться ни с чем. К примеру, если на сайте вебмастера проблемы с файлом robots.txt или неправильно настроен тег meta robots, ничего сделать не получится. Придется ждать, пока владелец проекта выйти на связь и разберется с ошибками.

Проблемы с индексацией ссылок на авторитетных сайтах возникают редко. Если контент регулярно обновляется и быстробот добавляет новые страницы в индекс, Google и Яндекс быстро обнаруживают проставленные ссылки и индексируют их.

Скорость появления бэклинков в консолях для вебмастеров зависит от многих факторов, поэтому нельзя однозначно сказать, когда ссылка начнет учитываться поисковиками. При наличии технических проблем у поисковых систем процесс обновления ссылочного профиля может затянуться надолго.

Часто бывает так, что при проверке сторонними сервисами находится гораздо больше бэклинков, чем в Google Search Console и Яндекс.Вебмастер. Это нормальная ситуация, но линки с основных ресурсов должны быть видны во всех источниках.

Факторы, которые влияют на индексацию ссылок

Опытные SEO-специалисты и вебмастера знают главное правило линкбилдинга: «Ссылки с трастовых и релевантных ресурсов на вес золота». Обычно с такими бэклинками не возникают проблемы, они быстро индексируются и приносят профит в виде хороших позиций. Особенно важна скорость индексации обратных ссылок при продвижении новых сайтов.

Что касается появления ссылки в консолях для вебмастеров, то данные могут обновляться с задержкой. Часто бэклинки пропадают из списка, а потом снова появляются. Это естественный процесс, на нём не стоит зацикливаться.

Факторы, влияющие на индексацию ссылок:

- Качество донора. Чем авторитетнее сайт в глазах поисковых систем, тем быстрее индексируются страницы и обратные ссылки. Как же проверить качество и траст донора, читайте в статье.

- Правильность размещения. Неактивные ссылки и URL, ссылающиеся на неосновное зеркало, могут не появиться в консолях для вебмастеров.

- Частота обновления контента. Ссылки с новостных проектов и других ресурсов с непрерывным процессом обновления информации индексируются гораздо быстрее.

- Техническое состояние. Если сайт часто падает, некорректно настроены каноникалы или страницы отдают неправильный код, могут возникнуть проблемы с попаданием линков в базу поисковых систем.

- Стабильность поисковиков. При глобальных обновлениях алгоритмов или масштабных изменениях в Google Search Console или Яндекс.Вебмастер новый контент может индексироваться с задержкой.

Если закупаете ссылки на качественных проектах и придерживаетесь четкого плана по линкбилдингу, проблем с индексацией и учетом бэклинков не будет. Следите за ситуацией, но в разумных пределах. Нет смысла несколько раз в день заходить в консоли для вебмастеров и обновлять страницу с внешними ссылками.

Как запретить индексацию сайта или отдельной страницы

Вы можете закрыть ресурс или определенную страницу от индексации. Зачем это делать? Дело в том, что поисковым роботам нравятся не все страницы. Тем более некоторые могут находиться в это время в разработке. Таким страницам точно лучше пока не попадаться ботам на глаза. Для этого вам достаточно запретить индексацию одним из предложенных способов:

- Командой Disallow в robots.txt. Здесь задаются правила для ботов: какие страницы разрешено сканировать, а какие под запретом. Задайте команду Disallow затем, чтобы закрыть доступ для поискового робота.

- Тегом noindex в HTML-коде страницы. Один из наиболее легких способов. Вы запрещаете боту индексировать определенную страницу или тип страниц.

- Авторизацией. На некоторых страницах можно закрыть доступ посредством формы авторизации. Этот способ считается наиболее надежным, поскольку в случае с командой Disallow и тегом noindex сайт все же может оказаться в выдаче. Это актуально для тех страниц, на которые идут ссылки с других.

Возможность закрытия страницы от индекса необходима в работе с ресурсами. Обязательно пользуйтесь такой опцией, чтобы более результативно раскручиваться в поисковой системе.

Документальное оформление индексации

Любое изменение условий трудового договора возможно только по письменному соглашению его сторон (ст. 72 ТК РФ). Поэтому, если решение об индексации принято, необходимо оформить ряд документов.

Дополняем коллективный договор

Если индексация заработной платы в локальных нормативных актах организации не была предусмотрена, их нужно дополнить соответствующим разделом.

Как правило, инициатива о внесении такого пункта исходит от представителей трудового коллектива, например профкома. Члены профкома на своем собрании формулируют соответствующее предложение. Не исключен вариант, что инициативу проявит администрация. В любом случае это предложение выносится на общее собрание трудового коллектива (или конференцию его представителей). Одобрение предложения об индексации общим собранием (конференцией) является основанием для внесения соответствующего положения в коллективный договор.

Фрагмент протокола общего собрания трудового коллектива с решением включить пункт об индексации в коллективный договор смотрите ниже.

Фрагмент протокола общего собрания трудового коллектива

В коллективном договоре следует прописать порядок увеличения оплаты труда с учетом роста цен, уровня инфляции и т. п., а также указать:

- периодичность индексации (месяц, квартал, полугодие, год) или дату ее проведения;

- какие конкретно выплаты в рамках системы оплаты труда подлежат индексации (оклад, премии, доплаты);

- порядок выбора (определения) коэффициента индексации.

Некоторые организации устанавливают основания ограничения размера индексации или отказа от ее проведения (например, финансовые трудности). Но если такие основания не указаны, работодатель не вправе в одностороннем порядке отказаться от индексации зарплаты или произвольно уменьшить коэффициент.

Согласно статье 44 ТК РФ дополнения в коллективный договор вносятся в порядке, установленном для его заключения Трудовым кодексом либо этим же коллективным договором (фрагмент приведен ниже).

Фрагмент коллективного договора

Норма коллективного договора — основание для издания приказа о проведении индексации.

Приказ о проведении индексации

На основании записи в коллективном договоре руководитель предприятия издает приказ в произвольной форме (образец приведен ниже).

Приказ об индексации

Вносим изменения в штатное расписание

На основании приказа руководителя изменения вносятся в штатное расписание1Штатное расписание не обязательный документ. Но если в компании он есть, при проведении индексации в нем нужно отразить новые размеры окладов. — Примеч. ред..

Изменение штатного расписания — это, как правило, отдельный документ, который можно разработать на базе формы № Т-3 , утвержденной постановлением Госкомстата России от 05.01.2004 № 1.

Вариант, предложенный редакцией журнала, смотрите ниже.

Фрагмент изменения штатного расписания

Как рассчитать величину нового оклада по каждой должности, покажем на примере.

Мы уже говорили, что порядок индексации заработной платы должна разработать организация. Рассмотрим порядок расчета, если коэффициент повышения соответствует величине инфляции, заложенной в бюджете на текущий год.

Пример

Согласно штатному расписанию, действующему с 1 января 2011 года, оклад старшего бухгалтера ЗАО «Строительная компания “Русский дом”» — 30000 руб. Коэффициент индексации соответствует величине инфляции, заложенной в бюджете на следующий год, — 1,06.Необходимо определить величину нового оклада по этой должности.

Решение.

Порядок расчета суммы нового оклада установлен в коллективном договоре. Применив его, получим 31800 руб. (30000 руб. * 1,06).

Последовательно используя данную формулу ко всем должностям и профессиям, перечисленным в штатном расписании, получим новые оклады по всем работникам штата.

Итоги расчетов оформим документально (выше).

Оформляем дополнительные соглашения

Условия оплаты труда (в том числе размер тарифной ставки или оклада работника, доплаты, надбавки и поощрительные выплаты) — обязательные условия трудового договора (ч. 2 ст. 57 ТК РФ). Поэтому при проведении индексации нужно оформить дополнительные соглашения к трудовым договорам, в которых будут отражены новые размеры окладов (ставок) (образец документа приведен ниже).

Дополнительное соглашение к трудовому договору

Ошибки индексации

Убедитесь, что ваш сайт вообще открыт для поисковых роботов. Это очень распространенная проблема. Часто разработчики, когда делают сайт, закрывают его от индексации. Когда разработчики сдают проект заказчику, то они могут забыть открыть сайт для роботов. Владелец сайта может не знать об этом и ждать появления сайта в поиске. Когда у меня заказывают аудит сайта, то проблема с индексацией одна из лидирующих. Также проверьте главное зеркало сайта: иногда второстепенные зеркала попадают в поисковый индекс, что приводит к проседанию позиций основного зеркала.

robots.txt

Есть два способа закрыть (и открыть) сайт и отдельные его страницы для поисковых роботов. Первый — файл robots.txt. Данный файл лежит в корневом каталоге сайта и может быть найдет по адресу https://вашсайт.ru/robots.txt

Данный файл создается специально для поисковых роботов и содержит перечень страниц, индексация которых не нужна. Это могут быть служебные страницы типа корзины, авторизации, восстановления пароля и так далее. Но нередко в этот файл попадают и нужные страницы.

В первую очередь нужно убедиться, в что в файле нет директивы

User-agent: * Disallow: /

Именно Disallow: / полностью закрывает сайт от индексации.

Также следует убедиться, что в файле не блокируются нужные страницы.

Лучшая тактика: заранее погуглить шаблон robots.txt для вашего движка на этапе выбора CMS и после запуска сайта залить файл в корень.

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Disallow: /tag Disallow: /category Disallow: /archive Allow: /*.css Allow: /*.js User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Disallow: /*amp/ Disallow: /tag Disallow: /category Disallow: /archive Allow: /*.css Allow: /*.js Sitemap: https://yourdomain.com/sitemap.xml

Если ваш сайт использует AMP, то в robots.txt предусмотрена директива Disallow: /*amp/ для Яндекса. Можете ее убрать, если не используете AMP. Также не забудьте подставить адрес вашего sitemap в конце файла.

Noindex

Второй распространенный спопособ закрыть страницу от роботов — специальный мета-тег. Находится в блоке <head> и выглядит он так:

<meta name="robots" content="noindex, nofollow" />

Noindex означает, что поисковикам не следует индексировать страницу. Nofollow — переходить по всем ссылкам на ней. Если помните, паук индексирует страницу и переходит по ссылкам на ней. Так страница и ссылки будут индексироваться без проблем:

<meta name="robots" content="index, follow" />

Убедившись, что сайт открыт для поисковых роботов, переходим к следующему этапу.

Используем панель Вебмастера

Каждая поисковая система имеет свою панель инструментов, специально предназначенную для вебмастеров. С помощью этой панели можно увидеть общее количество проиндексированных страниц. Рассмотрим на примере самых популярных ПС (Яндекс и Google), как выполнять такую проверку.

Чтобы использовать панель инструментов Яндекс в данном контексте, нужно завести аккаунт (если его еще нет), зайти в панель и добавить в нее свой сайт. Там будет показано общее количество страниц, которые уже проиндексированы.

Для использования панели инструментов Google также нужно обзавестись аккаунтом, чтобы иметь возможность зайти в панель. В нее нужно добавить свой сайт и зайти на вкладку «Состояние / Статус индексирования». Здесь также будет показано количество проиндексированных страниц.

Нередко можно заметить, что панель Вебмастера Google может показать значительно большее количество проиндексированных страниц, чем панель инструментов Яндекс. Представим, что на сайте 70 уникальных страниц, которые проиндексировались. И, скажем, Яндекс насчитал приблизительно такое количество ссылок, а Гугл, например, 210. Получается, что Яндекс показал правильное число, а Гугл в 3 раза больше. Так в чем же дело? А дело в дублях страниц, генерируемых движком WordPress. Такие дубли поисковикам не по душе. Использование robots.txt позволяет игнорировать индексацию дублей страниц поисковыми системами. И если на Яндекс это действует, то с Гуглом в этом плане могут возникать проблемы, так как он может действовать по своему усмотрению.

Есть также специальный сервис Pr-cy.ru, позволяющий получить вебмастерам различные данные по сайтам – в том числе, число страниц, проиндексированных в Гугле и Яндексе. Чтобы узнать эту информацию, нужно посмотреть на две нижние колонки соответствующих поисковых систем.

Что помогает ускорить индексацию сайта

Чтобы страницы быстрее индексировались, нужно придерживаться главных правил:

Регулярное размещение уникальных и оптимизированных статей. Поисковый робот возьмет себе за привычку регулярно посещать тот сайт, на котором с определенной периодичностью размещается качественный, полезный и интересный контент.

Анонсирование о размещении нового контента или полезных обновлениях на сайте через социальные сети. После того, как появилась статья, можно самостоятельно сообщить об этом в социальную сеть с помощью кнопки retweet. Поисковый бот отметит это и зайдет на сайт через социальную сеть значительно быстрее.

Поисковому роботу гораздо проще найти конкретную страницу с помощью ссылки, имеющейся на вашем сайте

То есть, не стоит забывать о важности внутренней перелинковки.

Добавив xml-карту в панель вебмастера, мы даем возможность поисковому боту пройти по ней. Также ее нужно добавить в robots.txt

Полезна и карта сайта (карта для человека), по которой бот отыщет все страницы сайта.

В материале мы рассмотрели основные способы, позволяющие проверить, попали ли страницы сайта в индекс различных поисковых систем. Некоторые из них более эффективные, а какие-то – менее, но каждый из них имеет право на существование и использование.

Читайте далее:

Методы ускорения индексации сайта в яндексе

Seo – проверка индексации текста и веса ссылок тест

Быстрая индексация сайта в Гугле

Проверить картинки на уникальность

Популярные бесплатные CMS системы

Как скрыть персональные данные в поисковых системах?

Как ускорить индексацию сайта в поисковых системах

Есть несколько

способов:

Добавление страницы с помощью Search Console

Это самый быстрый и простой способ

проиндексировать страницу. Обычно он занимает от нескольких секунд до

нескольких минут. По истечении этого времени ваш ресурс станет видимым для Google. Просто вставьте полный адрес страницы для индексации и нажмите запросить

индексацию в специальном окошке.

Добавление страницы в индекс через карты XML

XML-карта разработана для роботов Google. Он должен быть на всех страницах, потому что формат XML значительно упрощает индексацию страницы в Гугл. Карта XML – это совокупность всей информации об URL-адресах и подстраницах ресурса. В XML также содержится вся информация обо всех обновлениях ресурса.

Как только нам удастся создать карту сайта,

добавьте ее в поисковую систему Google. Благодаря этому роботы

будут знать, где найти данную карту сайта с ее данными. Чтобы отправить карту XML в Гугл, используйте Google Search Console. Когда карта будет обработана, вы сможете отображать статистику на

заданной странице и любую полезную информацию об ошибках.

Индексирование с PDF

Все больше и больше компаний решают размещать

на своих сайтах тексты в формате PDF. Если текст находится в

этом формате, Google может обработать изображения для извлечения

текста.

Как обрабатываются ссылки в файлах PDF? Ссылки в PDF обрабатываются точно так

же, как ссылки на веб-страницах. Стоит помнить, что там должны быть размещены

запрещенные для подписки ссылки. Чтобы проверить индексацию файлов PDF, введите фразу в поисковике вместе с аннотацией PDF.

Индексирование веб-сайтов с помощью онлайн-инструментов

Это базовая и очень простая форма индексации.

Это делается через несколько обратных ссылок

Есть много инструментов этого

типа, большинство из них платные или имеют ограниченную бесплатную версию.

Индексирование с помощью онлайн-инструментов важно для ссылок и страниц, к

которым у нас нет доступа. Добавив их в индексацию, Google Robot сможет свободно перемещаться по ним

Бюджет сканирования – это бюджет сканирования

вашего ресурса. В частности, краулинговый бюджет – это количество страниц,

проиндексированных Google на вашем сайте роботами

Гугл за одно посещение.

Это зависит от размера вашего ресурса и его

состояния, т. е. Ошибок, с которыми сталкивается Гугл, и, конечно же, от

количества ссылок на ваш ресурс. Роботы ежедневно индексируют миллиарды под-страниц,

поэтому каждое такое посещение загружает некоторые серверы со стороны владельца

и Google.

На краулинговый бюджет наибольшее влияние

оказывают два параметра:

- Crawl Rate Limit – ограничение скорости индексации страницы;

- Crawl Demand – частота, с которой сайт индексируется.

Crawl Rate Limit это ограничение, введенное для

предотвращения одновременного сканирования слишком большого количества страниц

в Google. Оно было разработано для обеспечения защиты

от возможной перегрузки сайта. Основная цель ограничителя состоит в том, чтобы Гугл

не отправлял слишком много запросов, которые замедлили бы скорость вашего ресурса.

Это также может зависеть от скорости веб-сайта, если она слишком медленная,

замедляется темп всего процесса. Тогда Google сможет проанализировать только некоторые из ваших подстраниц. На

ограничение скорости сканирования также влияет ограничение, установленное в Google Search Console. Владелец сайта может изменить значение лимита через панель.

Требование сканирования основано на

технических ограничениях. Если страница представляет ценность для

потенциального пользователя, робот с большей вероятностью ее посетит. Возможно,

даже если ограничение скорости сканирования не используется, ваш веб-сайт не

будет проиндексирован. На это могут повлиять два фактора:

- популярность, т. е. адреса, которые посещают

большее количество пользователей, чаще посещаются роботами; - актуальность – алгоритмы проверяют, насколько

часто сайт обновляется.

Вывод

Есть много способов проиндексировать страницу

в Google и Яндекс. Самые популярные из них:

- добавление страницы в Яндекс Вебмастер;

- индексация с помощью Search Console;

- карты XML;

- индексирование файлов PDF;

- индексация веб-сайтов с помощью

онлайн-инструментов.

Любой владелиц ресурса, если он хочет

добиться успешного развития своего ресурса, должен работать над его оптимизацией под поисковые системы. Это наиболее

верный способ сделать сайт более популярным и увеличить доход от рекламы. Для

успеха в деле оптимизации лучше всего обратится к профессионалам, которые помогут устранить все препятствия на пути популяризации

Интернет-ресурса.