Как скачать весь сайт: есть бесплатная программа

Содержание:

- Скопировать из браузера

- Как сохранить страницу с интернета на компьютер

- Сохранение картинок и шрифтов

- Установка и использование HTTrack

- Настройка параметров закачки

- Какие есть ограничения у копий

- Онлайн-сервисы

- Скриншот

- Скачиваем сайт целиком на компьютер с помощью wget

- Как можно скачать сайт на компьютер полностью

- Специальные программы для скачивания сайтов

- Установка программы WinHTTrack Website Copier

- Копируем сайт

- Обзор методов копирования

Скопировать из браузера

Можно перенести данные из обозревателя в любой текстовый редактор. Для этого лучше всего подойдёт Microsoft Word. В нём корректно отображаются изображения и форматирование. Хотя из-за специфики документа может не очень эстетично выглядеть реклама, меню и некоторые фреймы.

Вот как скопировать страницу сайта:

- Откройте нужный URL.

- Нажмите Ctrl+A. Или кликните правой кнопкой мыши по любой свободной от картинок и flash-анимации области и в контекстном меню выберите «Выделить». Это надо сделать для охвата всей информации, а не какого-то произвольного куска статьи.

- Ctrl+C. Или в том же контекстном меню найдите опцию «Копировать».

- Откройте Word.

- Поставьте курсор в документ и нажмите клавиши Ctrl+V.

- После этого надо сохранить файл.

Иногда получается так, что переносится только текст. Если вам нужен остальной контент, можно взять и его. Вот как скопировать страницу веб-ресурса полностью — со всеми гиперссылками, рисунками:

- Проделайте предыдущие шаги до пункта 4.

- Кликните в документе правой кнопкой мыши.

- В разделе «Параметры вставки» отыщите кнопку «Сохранить исходное форматирование». Наведите на неё — во всплывающей подсказке появится название. Если у вас компьютер с Office 2007, возможность выбрать этот параметр появляется только после вставки — рядом с добавленным фрагментом отобразится соответствующая пиктограмма.

Способ №1: копипаст

В некоторых случаях нельзя скопировать графику и форматирование. Только текст. Даже без разделения на абзацы. Но можно сделать скриншот или использовать специальное программное обеспечение для переноса содержимого страницы на компьютер.

Сайты с защитой от копирования

Иногда на ресурсе стоит так называемая «Защита от копирования». Она заключается в том, что текст на них нельзя выделить или перенести в другое место. Но это ограничение можно обойти. Вот как это сделать:

- Щёлкните правой кнопкой мыши в любом свободном месте страницы.

- Выберите «Исходный код» или «Просмотр кода».

- Откроется окно, в котором вся информация находится в html-тегах.

- Чтобы найти нужный кусок текста, нажмите Ctrl+F и в появившемся поле введите часть слова или предложения. Будет показан искомый отрывок, который можно выделять и копировать.

Если вы хотите сохранить на компьютер какой-то сайт целиком, не надо полностью удалять теги, чтобы осталась только полезная информация. Можете воспользоваться любым html-редактором. Подойдёт, например, FrontPage. Разбираться в веб-дизайне не требуется.

- Выделите весь html-код.

- Откройте редактор веб-страниц.

- Скопируйте туда этот код.

- Перейдите в режим просмотра, чтобы увидеть, как будет выглядеть копия.

- Перейдите в Файл — Сохранить как. Выберите тип файла (лучше оставить по умолчанию HTML), укажите путь к папке, где он будет находиться, и подтвердите действие. Он сохранится на электронную вычислительную машину.

Защита от копирования может быть привязана к какому-то js-скрипту. Чтобы отключить её, надо в браузере запретить выполнение JavaScript. Это можно сделать в настройках веб-обозревателя. Но из-за этого иногда сбиваются параметры всей страницы. Она будет отображаться неправильно или выдавать ошибку. Ведь там работает много различных скриптов, а не один, блокирующий выделение.

Если на сервисе есть подобная защита, лучше разобраться, как скопировать страницу ресурса глобальной сети другим способом. Например, можно создать скриншот.

Как сохранить страницу с интернета на компьютер

Каждый интернет-браузер имеет функцию сохранения веб-страниц на ноутбук или компьютер. Рассмотрим пример сохранения страницы сайта в популярном браузере Opera.

Для этого перейдём в браузер Opera на нужную для нас веб-страницу, чтобы скопировать её. Переходим на кнопку, которая находится в левом верхнем углу браузера и открываем меню. После нажимаем на вкладку «Страница», чтобы увидеть пункт «Сохранить как…» Тот же самый результат будет, если нажмёте комбинацию Ctrl+S.

Далее, нужно нажать на «Сохранить как…» и выбрать место на диске, куда вы желаете сохранить файл. Выберете тип файла и сохраняйте. Выбранная страница сайта сохранится в нужном формате и расширением html. Это очень удобный формат. В нём текст и все элементы сайта вместе с картинками сохранятся полностью и в одном файле. Браузер Internet Explorer тоже может сохранять в таком формате.

Если при сохранении выбрать тип файла «HTML с изображениями», то создаётся не только файл с таким расширением. Вместе с этим будет создан отдельный каталог, где будут храниться картинки и прочие элементы. Хотя страница и полностью сохранится, такой вариант архивации не очень удобен.

Иногда, копируя нужную информацию на флеш-карту, каталог с картинками может не поместиться по каким-либо причинам. Например, загруженность флеш-карты или большая величина самого каталога с картинками. В этом случае возникнет неудобство при открытии сохранённого сайта. Он будет открываться в виде текста без картинок. Поэтому такой вариант устроит далеко не всех.

Если картинки вас не очень интересуют, то всю страницу можно скопировать в текстовом формате. Файл будет храниться на компьютере или флеш-карте с расширением txt. Или выделить фрагмент нужного текста и скопировать в Word. После чего документ будет сохранён с соответствующим расширением этой программы.

Аналогично сохранить веб-страницу можно и в других браузерах. Хотя существуют некоторые нюансы.

- В Google Chrome команда «Сохранить страницу как…» выполняется из пункта настроек и управления. Меню расположено в правом верхнем углу. При этом следует заметить, что сохранение в текстовый и архивный файл Chrome не поддерживает.

- В Mozilla Firefox пункт «Сохранить как…» появится, если нажать на кнопку «Файл» в появившемся меню.

- Internet Explorer страница сохраняется аналогично вышеуказанным браузерам.

Мы уверены, что Вам будет полезна статья о том, как пользоваться торрентом.

Сохранение веб-страницы в PDF формате

Скачать страницу через веб-браузер на ноутбук или компьютер не каждому покажется удобным. Поскольку, кроме неё, создаётся каталог с изображениями, а также масса других отдельных элементов. Для наиболее компактного сохранения страницы можно преобразовать её в PDF файл. Эта возможность есть в браузере Google Chrome, который сохранит её в этом формате полностью.

Для этого нужно зайти в «управление и настройки» из меню и нажать на команду «Печать». В появившемся окне печати документа и подпункте «Принтер» кликнуть на кнопку «Изменить». Появятся все доступные принтеры и строчка «Сохранить как PDF». Нужно нажать на «Сохранить» и указать место на диске, куда будет сохранена интернет-страница. После чего её можно будет преобразовать практически в любой формат с помощью специальных конверторов.

Сохранение через скриншот

Ещё один вариант сохранения веб-страницы в виде картинки при помощи скриншота. Для этого нажмите комбинацию Shift+Print Screen. При этом сохранится область страницы, которая находится в рамках экрана. Если текст входит не весь можно уменьшить захват экрана путём изменения масштаба. После сохранения можно использовать любой графический редактор для различных корректировок.

А также можно использовать специальные программы для создания скриншотов. Одной из таких программ является Clip2net. Она довольна популярна из-за своей многофункциональности и простоты в использовании. Скачать её можно бесплатно с официального сайта. После создания скриншотов она сохранит их в любую указанную вами папку. А также ими можно будет обмениваться через интернет даже с помощью созданных ею ссылок.

Сохранение картинок и шрифтов

Помимо сервисов онлайн для скачивания интернет-сайтов, существуют и специальные программы для этого. Как и сервисы, они требуют наличия интернет соединения, но для работы им необходим только адрес сайта.

HTTrack WebSite Copier

Бесплатная программа с поддержкой русского языка, операционных систем, не относящихся к семейству Windows, а главное – бесплатная. В меню установки доступен только английский, однако уже при первом запуске в настройках есть возможность установить русский или любой другой. По умолчанию создает на системном разделе папку «Мои сайты», куда и будут сохраняться все загруженные интернет-порталы. Имеет возможность дозагрузить сайт, если по какой-то причине загрузка прервалась.

Главное окно программы HTTrack WebSite Copier

Также есть ряд настраиваемых параметров:

- тип контента – позволяет задавать доступность изображений, видео и прочих медийных составляющих;

- максимальная глубина скачивания – доля доступного функционала. Большинству сайтов подходит глубина – 3-4 уровня;

- очередность скачиванию – задает приоритет загрузки текста или медиа-файлов.

Возможно вас заинтересует: Как расшарить файлы и папки в локальной сети и интернет (общие папки)

К недостаткам можно отнести частично утративший актуальность интерфейс.

Использование:

- Скачать программу из надежного источника.

Скачиваем программу из официального источника

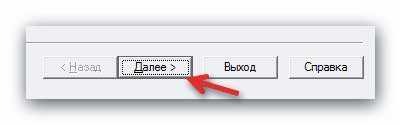

- Кликнуть «Далее», чтобы создать новый проект.

Нажимаем «Далее»

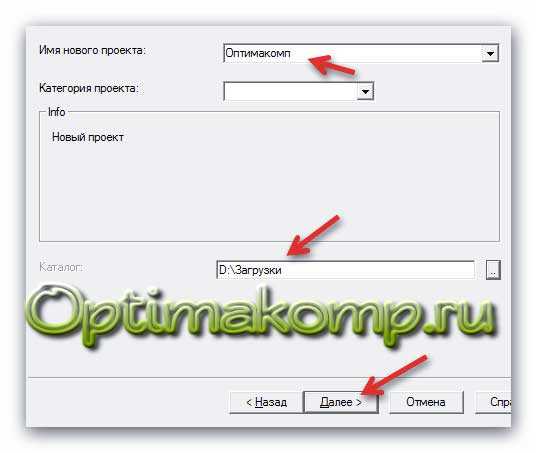

- Ввести имя, под которым будет находиться сохраненный сайт, выбрать путь для загрузки файла, нажать «Далее».

Вводим имя, под которым будет находиться сохраненный сайт, выбираем путь для загрузки, нажимаем «Далее»

- Задать адрес сайта и тип содержимого, которое будет загружаться.

Задаем адрес сайта и тип содержимого

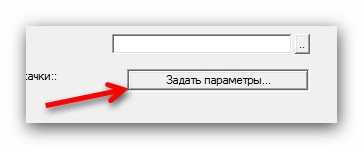

- Настроить глубину загрузки — количество подразделов сайта, щелкнув по опции «Задать параметры».

Щелкаем по опции «Задать параметры»

- Во вкладке «Прокси» оставить настройки по умолчанию или убрать галочку с пункта «Использовать прокси…».

Во вкладке «Прокси» оставляем все по умолчанию

- В закладке «Фильтры» отметить флажками пункты, которые нужно исключить.

Во вкладке «Фильтры» отмечаем нужные пункты

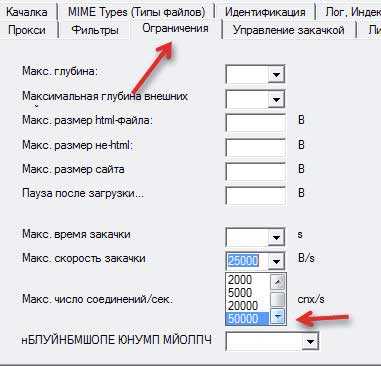

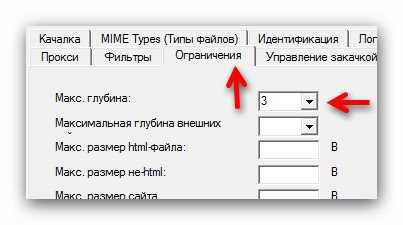

- Перейти во вкладку «Ограничения» в полях задать максимум и минимум, как на скриншоте.

Во вкладке «Ограничения» выставляем значения максимальное и минимальное, как на фото

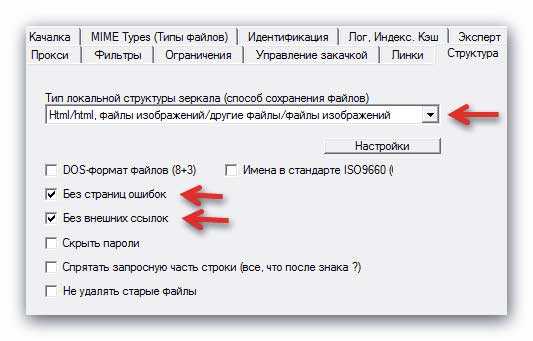

- Во вкладке «Линки» отметьте пункты, как на фото.

Отмечаем пункты, как на скриншоте

- Перейти во вкладку «Структура», в разделе «Тип структуры…» выбрать параметр «Структура сайта (по умолчанию)», нажать «ОК».

Во вкладке «Структура» выбираем в параметре «Тип…» структуру сайта по умолчанию, нажимаем «ОК»

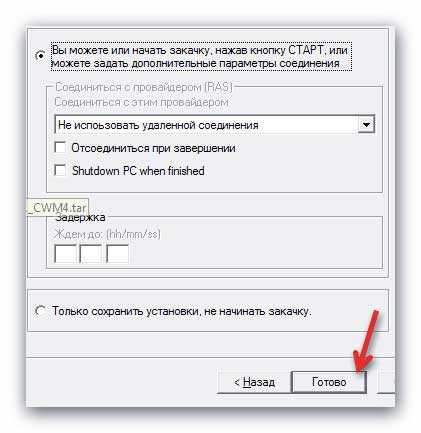

- Выбрать тип соединения, при необходимости — выключение компьютера после завершения. Нажать «Готово».

Выставляем настройки, как на скриншоте, нажимаем «Готово»

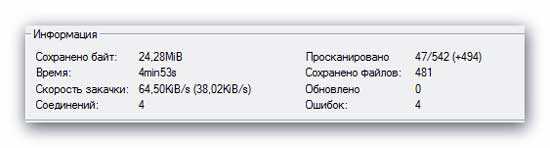

- Дождаться завершения процесса скачивания.

Процесс скачивания сайта, ожидаем завершения

Teleport Pro

Программа с простым и понятным интерфейсам, дружелюбным даже для новичка. Способна искать файлы с определенным типом и размером, а также выполнять поиск, использую ключевые слова. При поиске формирует список из всех файлов со всех разделов ресурса. Однако, у нее хватает и недостатков. Главный из них – платная лицензия. 50 долларов далеко не каждому по карману.

Возможно вас заинтересует: Как поменять мак адрес компьютера

Интерфейс программы Teleport Pro

Кроме того в настройках отсутствует русский язык, что сделает еще более сложным пользование людям, не владеющим английским. Также эта программа несовместима с «альтернативными» ОС для обычных компьютеров (не «маков»), и в завершении «минусов» программы – она обладает очень старым интерфейсом, что может не понравиться людям, привыкшим работать на последних версиях Windows.

Offline explorer Pro

Интерфейс программы Offline explorer Pro

Еще одна лицензионная программа. По сравнению с упомянутыми выше, функционал значительно расширен: можно загружать даже потоковое видео, интерфейс более привычен для современных операционных систем. Может обрабатываться до 500 сайтов одновременно, включая запароленные. Программа имеет собственный сервер, что делает ее гораздо автономней прочих программ, не говоря уже об онлайн-сервисах. Позволяет переносить сайты прямиком из браузера.

Главный недостаток большая цена: 60 долларов за стандартную версию, 150 – за профессиональную и целых 600 – за корпоративную. Такие цены делают ее доступной только для узкого круга пользователей.

Установка и использование HTTrack

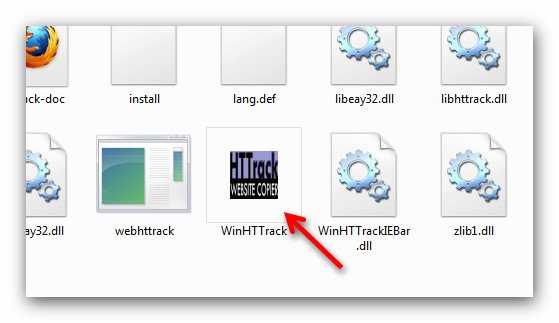

Что касается портабельных версий — тут всё просто. Заходим в папку, находим такой ярлык и кликаем на него…

А вот, как установить обычную версию…

Установили. Теперь сам процесс скачивания сайта.

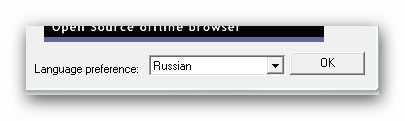

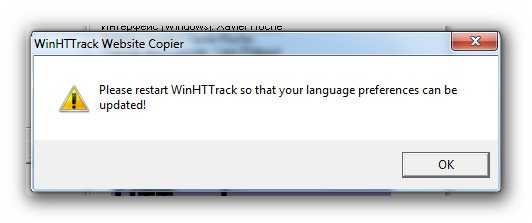

Выбираем русский язык. Это делается один раз. Программа попросит перезапуск — делаем.

…

…

Получили великий и могучий.

Создаём проект…

В качестве каталога лучше создать заранее отдельную папку.

Задаём параметры — очень важный момент. Помните — «Как мы лодку назовём…» — так и скачаем сайт.

Тут есть подводный камень. Максимальную скорость закачки можно и нужно выставить вручную, что и делаем…

Можно задать отключение сети или выключение компа по завершении закачки. Этот процесс не всегда быстрый. Зависит от скорости соединения и размера сайта.

Я прошляпил завершение закачки, но примерно могу сказать, что этот сайт скачался примерно за 15-20 минут и размер составил более 100 МБ.

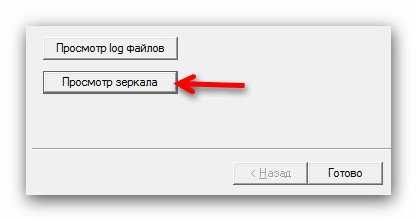

Теперь можно просмотреть, что мы с Вами скачали…

Что тут смотреть — сайт, как сайт — более 160 статей. Отлично всё листается без подключения интернета. Что и требовалось доказать. Великолепно!

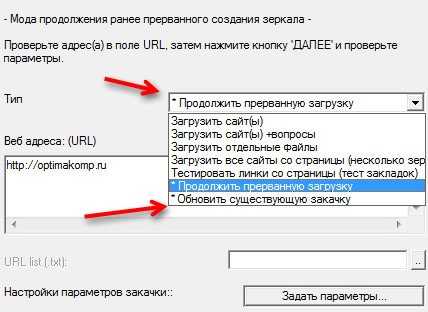

Если закачка прервалась — её всегда можно обновить или продолжить…

На флешку нужно переносить всю папку или только…

Тоже будет работать.

А для запуска на другом компьютере заходим в эту папку и кликаем…

Настройка параметров закачки

Тут во вкладке «Ограничения» нужно указать, на какую глубину (на сколько уровней) осуществлять переход по ссылкам. Также не лишним будет ограничить скорость закачки, чтобы не перегружать сервер сайта интенсивными запросами.

Другим важным моментом является указание типов файлов, которые необходимо загружать. Обычно сайт загружают вместе с картинками. А если на сайте есть музыкальные и видеофайлы, то их загрузка может оказаться нереальной задачей. Поэтому в каждом отдельном случае взвешивается целесообразность загрузки того или иного содержимого. И на основании этого составляется список допустимых и недопустимых к загрузке типов файлов. Задать этот список можно на вкладке «Фильтры».

В программе HTTrack содержится и множество других настроек, которые в отдельных случаях могут быть востребованы. Но в подавляющем большинстве случаев достаточно выставить только глубину сканирования и типы файлов.

Какие есть ограничения у копий

Хочу внести ясность, что скопированный проект, даже если он точь-в-точь будет выглядеть как оригинал, это не означает что будут работать все функции. Не будет работать функционал, который исполняется на сервере, т.е. различные калькуляторы, опросы, подбор по параметрам — работать не будут 99%. Если функционал реализован с помощью Javascript, то будет работать.

Но .php скрипты скачать с сервера НЕВОЗМОЖНО, вообще НИКАК. Также не будут работать формы обратной связи и подачи заявок без ручных доработок, кстати DollySites делает это. Учтите, что некоторые сайты имеют защиту от скачивания, и в таком случае вы получите пустую страницу или сообщение об ошибке.

Онлайн-сервисы

Как несложно догадаться из названия – это специальные сайты, с помощью которых можно скачать другие сайты из интернета

Преимущество данного подхода в том, что не нужно устанавливать дополнительных программ, и, соответственно, не важно какая операционная система установлена. Вроде бы всё классно – вставил имя сайта, нажал скачать, и получаешь готовый архив

Но на деле всё оказалось не настолько радужным.

Недостаток сервисов в том, что их мало, а те что есть, работают так себе, либо просят денег. Лично у меня ни разу не получалось скачать даже одностраничный сайт. Сервисы показывали процесс загрузки и зависали. Но тем не менее, список прилагаю:

- WebSiteDownloader — позволяет, якобы, выгрузить сайт в архиве, англоязычный

- R-Tools — платный с тарифной сеткой. На момент написания работал плохо, https не поддерживается, скаченный сайт открылся криво. Проект развивается, есть демо на 25 страниц.

В общем у меня сложилось впечатление, что эти сервисы либо глючат, либо грузят не совсем то, что хотелось бы, либо годятся только для маленьких сайтиков.

Скриншот

Снимок экрана — это самый простой способ добавить какую-то информацию на компьютер. Она сохраняется в виде графического файла. Его можно открыть и просмотреть в любое время. Вот как сделать скрин:

- Зайдите на нужный портал.

- Нажмите на клавиатуре кнопку PrintScreen (иногда она называется «PrntScr» или «PrtSc»). Снимок экрана будет добавлен в буфер обмена — временное хранилище, используемое при операциях «Копировать-Вставить».

- Откройте любой графический редактор. В операционной системе Windows есть свой — называется «Paint». Можете воспользоваться им. В нём можно обрезать и немного подкорректировать скриншот. Для более серьёзного редактирования графики надо устанавливать на компьютер профессиональные программы (Adobe Photoshop, к примеру). Но чтобы просто сделать копию страницы, хватит и собственных средств Windows.

- Вставьте скрин в редактор. Для этого нажмите Ctrl+V.

- Можно добавить его и в текстовый процессор (тот же Word), который поддерживает работу с графикой.

Получить снимок страницы можно с помощью графических редакторов. Например, Paint.

Информация будет представлена в виде сплошной картинки, а не набора символов. Если понадобится скопировать какую-то часть материала, придётся перепечатывать его вручную. Ведь скриншот — не статья. Чтобы облегчить задачу, воспользуйтесь утилитами для распознавания текста с рисунков.

Так удобно копировать небольшие куски. Но вот с объёмным контентом сложнее. Придётся делать много снимков, прокручивать, часто открывать редактор. Но можно разобраться, как сделать скрин всей страницы портала, а не её части. Используйте специализированные программы.

Утилиты для создания скриншотов

Существуют программы для работы со снимками экрана. С их помощью можно охватить контент полностью, а не скринить по кускам.

- Популярное приложение с разнообразным функционалом.

- Расширение для веб-браузера. Можно сделать картинку всей страницы, просто нажав кнопку на панели инструментов.

- Снимает всё, что можно снять: произвольные области, окна, большие веб-ресурсы. Есть инструментарий для редактирования получившихся изображений и библиотека эффектов.

- Автоматически прокручивает, делает серию кадров и самостоятельно объединяет их в один скриншот.

Есть также онлайн-сервисы, которые могут сформировать снимок. Они работают по одному принципу: вставить адрес сайта — получить картинку. Вот некоторые из них.

- Capture Full Page

- Web Screenshots

- Thumbalizr

- Snapito

Скачиваем сайт целиком на компьютер с помощью wget

Этот способ намного быстрее предыдущего. Скачиваем последнюю версию консольной программы wget здесь.

Подробно об этой программе написано в Википедии и сейчас нет необходимости расписывать все нюансы её работы.

Далее распаковываем архив и создаём на диске С в папке Program Files папку с названием wget. Затем вставляем файлы из корневой папки распакованного архива в только что созданную папку.

После этого находим на рабочем столе системный значок «Компьютер», кликаем правой кнопкой мыши по нему, открываем «Свойства», заходим в «Дополнительные свойства системы», «Перемены среды» и находим здесь строку «Path» в директории «Системные переменные» и жмём на кнопку «Изменить».

Перед нами появится строка, в конце которой нужно поставить точку с запятой и затем вставить скопированный путь к папке wget на диске С (C:Program Fileswget). Вставляем его после точки с запятой в строке и сохраняем всё.

После этого чтобы скачать сайт целиком на компьютер, открываем консоль windows в директории «Пуск» и вводим в командную строку cmd. После этого мы увидим консоль, куда вводим wget –h чтобы убедится, что данное приложение работает.

После копируем url нужного сайта и вводим wget –page-requisites -r -l 10 http://adress-sayta.com и запускаем консоль. (Параметр –page-requisites отвечает за то чтобы все картинки, шрифты и стили сайта скачались. Если оставить этот параметр и вставить в конце только url сайта, то загрузится только его главная страница. Поэтому нужно добавить ключи -l и -r и 10-ый уровень вложенности глубины загрузки.

Всё, скачивание сайта началось. Скопированные файлы теперь находятся на диске С в папке «Пользователи», «Admin» (на windows 7). В папке «Админ» находим папку сайта со всеми его файлами. Запускаем файл index.html и убеждаемся, что веб-ресурс скачан на компьютер полностью и он такой же, как он-лайн.

Как можно скачать сайт на компьютер полностью

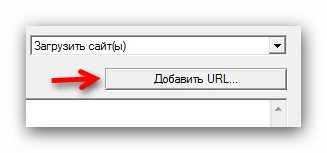

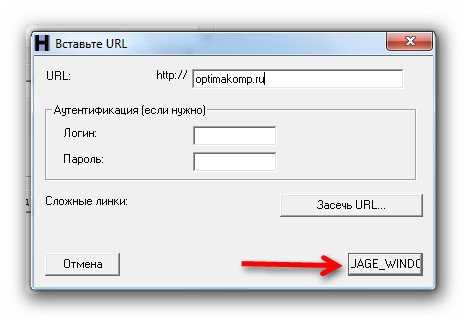

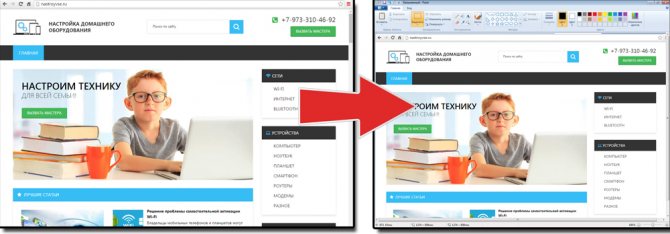

Процесс скачивания сайта целиком с помощью WinHTTrack я рассмотрю на примере своего ресурса, на котором вы сейчас находитесь.

Запускаем WinHTTrack и посередине экрана программы нажимаем на кнопку Далее >:

В новом окне указываем Имя нового проекта, Категорию проекта (для дальнейшего упорядочивания сохраненных сайтов) и путь сохранения — Каталог (где на компьютере будут храниться сохраненные сайты), который при желании можно изменить. Жмем Далее:

Причем у программы WinHTTrack Website Copier есть хорошая особенность. В ней можно в реальном времени наблюдать процесс скачивания сайта целиком. И при этом можно пропускать скачивание любых ненужных файлов:

Это может быть полезно, когда мы видим, что качается какой-нибудь большой видео-файл или ненужная нам программа.

Но можно также изначально (перед скачиванием сайта) задать параметры по своему желанию, чтобы, например, заранее исключить скачивание того, что нам не нужно.

Такую настройку параметров давайте рассмотрим немного подробнее.

А). Фильтры WinHTTrack для скачивания сайта

В данной вкладке можно дать задание программе: как при скачивании сайта поступать с некоторыми файлами.

Допустим, нам нужно скачать сайт целиком вместе со всеми картинками. При этом нам не нужны программы (файлы exe), архивы, а также видео и аудио, которые могут находиться на ресурсе. В таком случае мы ставим на всех группах файлов галочки и меняем вручную значок + на – для всех файлов, которые хотим исключить из закачки:

Как видим, вариантов для скачивания необходимой информации может быть много.

Б). Ограничения WinHTTrack при копировании сайта

В этой вкладке можно настроить некоторые параметры, ограничивающие какие-либо функции. При наведении на каждую ячейку курсором мыши, появляется пояснение выбранного ограничения, поэтому можно посмотреть, что означает каждое из них:

Две из них, на мой взгляд, самые часто используемые:

Максимальный размер сайта. Полезно в случаях, когда мы хотим ограничить скачивания сайта, ведь мы не знаем, сколько там информации на самом деле, а место у нас на компьютере может быть ограничено. Поэтому сами решаем, сколько можем уделить места на своем компьютере для этого сайта.

Максимальное время закачки сайта. Полезно в случаях, когда мы куда-нибудь собираемся и выходить уже нужно через полчаса-час, а нам нужно срочно скачать какой-нибудь сайт в дорогу почитать без Интернета. И здесь можно указать время, через сколько прекратить закачку, т.е. сколько успеем скачать – сколько и будет.

Остальные ограничения можете попробовать использовать самостоятельно, — они уже не так часто применимы и, может быть, не понадобятся никогда.

В). Линки WinHTTrack

Рекомендую в этой вкладке поставить галочку: получить вначале HTML файлы, чтобы сначала загрузились страницы сайта, а уже потом все остальное (картинки, видео, аудио и т.д.):

Остальные вкладки дают дополнительные возможности, но основное, что нужно для того, чтобы скачать сайт целиком, я описал в этой заметке. Начинающему пользователю, думаю, на остальное можно не обращать особого внимания.

Вот и всё! Осталось нажать на кнопку Далее и Готово:

И после закачки сайта можно переходить к его просмотру.

Специальные программы для скачивания сайтов

Разработчики приложений создают специальные программы, которые позволяют быстро скачать необходимый сайт в интернете. Для этого нужно знать, какие утилиты лучше применять, принципы их работы и прочие нюансы.

HTTrack WebSite Copier

Это приложение является лучшим среди бесплатных программ для сохранения интернет-страничек в оффлайн режиме. Скачать его можно с официального сайта разработчика или на других порталах.

Как пользоваться утилитой:

- для начала нужно скачать приложение на компьютер, установить и запустить;

- появится окно с настройками, где нужно будет выбрать язык, среди перечисленных вариантов выделяем русский;

- после этого откроется окно, где нужно подписать проект, указать категорию и место для загрузки сайта;

- далее, в специальной графе вводим адрес самого сайта для скачивания.

Через несколько минут программа автоматически загрузит все данные из веб-страницы в указанную папку на компьютере. Информация будет доступна в off-line режиме в файле index.htm.

Сама по себе утилита проста в использовании, интерфейс несложный, сможет разобраться любой пользователь. Есть возможность настроить программу под себя, например, запретить скачивать картинки с сайта или отметить только желаемые страницы. Среди плюсов можно выделить: бесплатную версию, простой интерфейс, быстрое сохранение сайта. Минусов не обнаружено, так как утилита имеет большое количество положительных отзывов со всего мира.

Teleport Pro

Продолжает список лучших программ Teleport Pro. Это одно из самых старых приложений, которое позволяет скачать сайт на компьютер. По сравнению с прошлой утилитой, эта программа платная, ее стоимость на официальном портале составляет $50. Для тех, кто не хочет платить, есть тестовая версия, которая даст возможность пользоваться приложением определенный период времени.

После скачивания и установки откроется главное окно утилиты, там нужно указать параметры для сохранения сайта. Предлагается выбрать такие варианты: сохранить загружаемую копию, дублировать портал, включая структуру, сохранить определенный тип файлов, сохранить все интернет-ресурсы, связанные с источником, загрузить файлы по указанным адресам, скачать страницы по ключевым словам.

Далее создается новый проект, где указывается адрес самого сайта, а также папка для сохранения данных. Чтобы запустить программу, нужно нажать на кнопку «Start». Оффлайн доступ к файлам сайта будет открыт уже через несколько минут.

https://youtube.com/watch?v=Q3n9vsrE9P4

Положительные стороны приложения – простота в использовании, удобное и быстрое скачивание. Среди минусов стоит выделить платную версию, которую смогут купить далеко не все пользователи.

Offline Explorer Pro

На этом список программ для скачивания сайтов не заканчиваются. Есть еще одна платная утилита, которая имеет большое количество функций и возможностей. На официальном сайте можно скачать бесплатную версию, но она будет иметь ряд ограничений на сохранение файлов. Полная версия приложения делиться на три пакета: Standard, Pro и Enterprise. Стоимость стандартной утилиты обойдется в $60, а с расширением Pro – $600.

Как и в большинстве программ, процесс скачивания начинается с создания нового проекта. Там вводится название, веб-адрес, необходимая папка на компьютере. Также сеть большое количество настроек, которые позволяют скачать только самую нужную информацию. Предлагается сохранить только текст или с картинками. Программисты и разработчики сайтов точно ее оценят.

После регулировки параметров нужно нажать на кнопку «Загрузка», и утилита начнет сохранять файлы на ПК. Скачивание длится недолго, уже через несколько минут данные сайта будут в папке. Преимущества – многофункциональность, доступна русская версия, быстрая загрузка. Недостатки – только платная версия, которая стоит недешево.

Webcopier

Еще одно платное приложение, которое имеет бесплатную версию, действующую 15 дней. Процесс работы похож на предыдущие программы. Необходимо создать новый проект, заполнить информацию о сайте, ввести адрес и указать папку для загрузки. Нажатие кнопки «Start download» позволит запустить работу утилиты. Скорость скачивания среднее, ниже, чем у других программ. Приобрести полную версию можно за $40.

Плюсы – приятный интерфейс, удобные настройки, простое управление.

Минусы – платная версия.

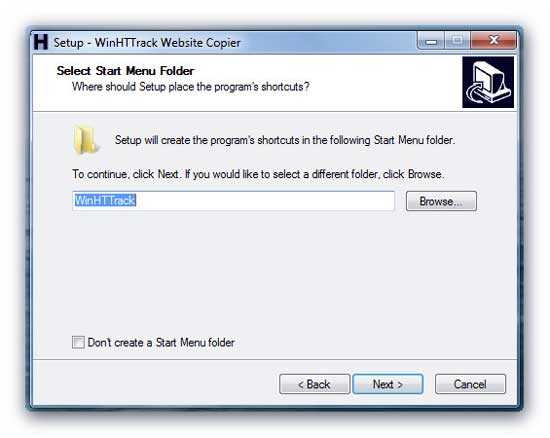

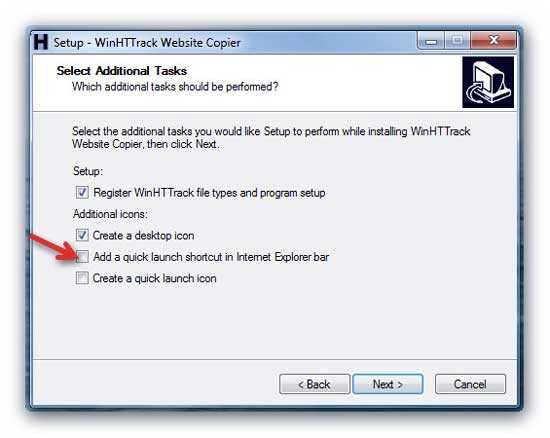

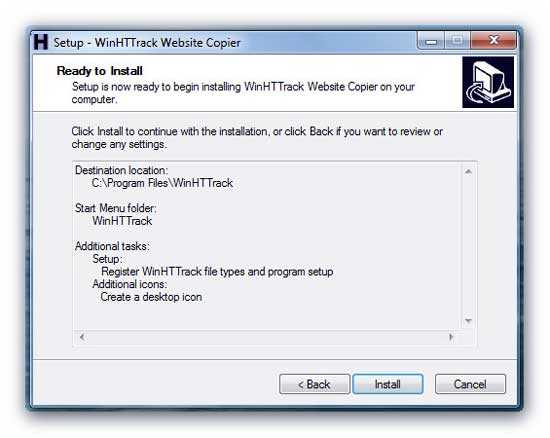

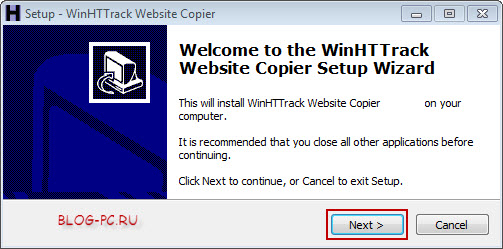

Установка программы WinHTTrack Website Copier

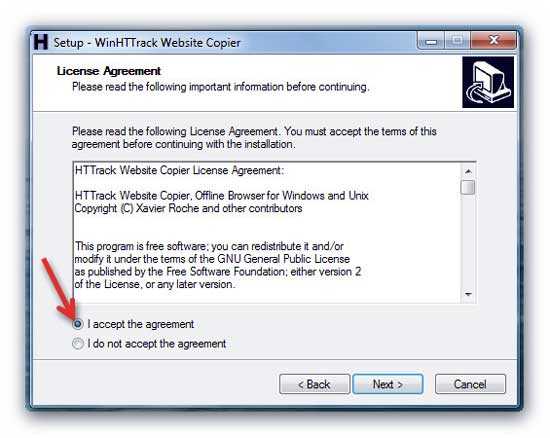

Установка WinHTTrack начинается с приветственного окна, в котором просто жмем Next:

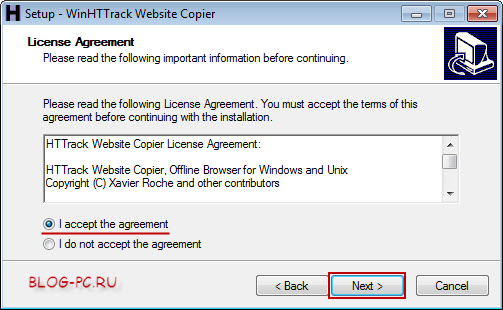

Соглашаемся с условиями и идем дальше:

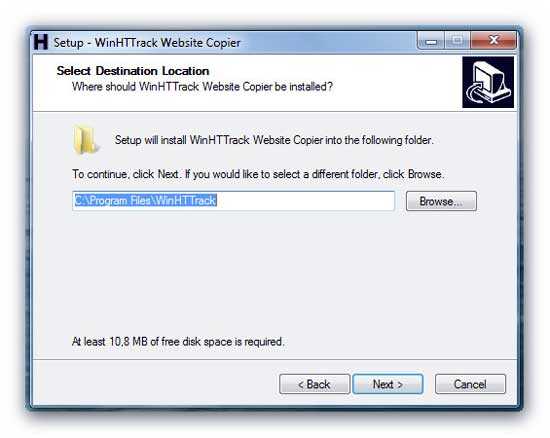

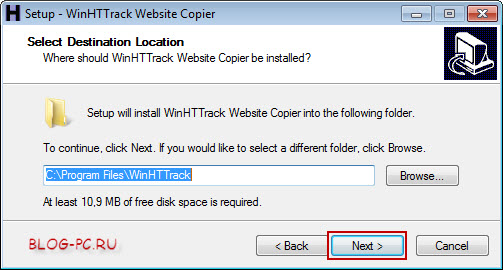

Далее показывается, где на компьютере будет установлен WinHTTrack. Ничего не меняя, идем далее:

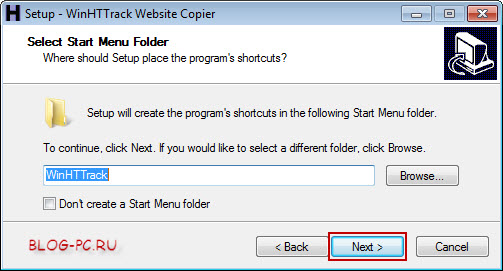

Указывается, какое будет название папки в меню Пуск для запуска WinHTTrack. Так же, здесь можно ничего не менять. Идем далее:

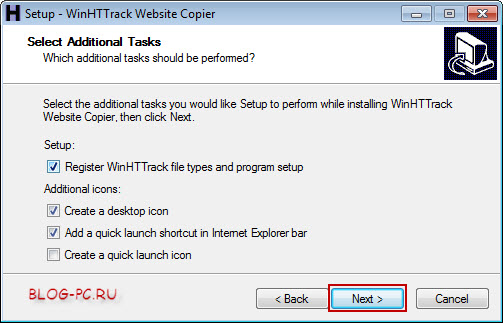

Оставляем всё, как предлагается по умолчанию, и жмем Next:

В следующем окне показываются выбранные параметры. Просто жмем Install для завершения установки.

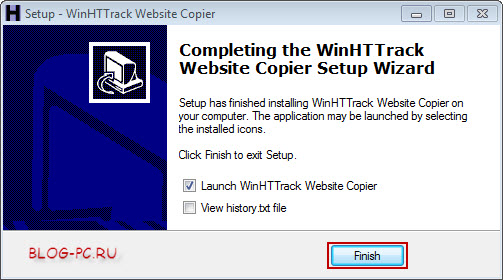

Появится следующее окно, в котором оставляем галочку на Launch WinHTTrack Website Copier. Это если мы хотим запустить программу сразу же после установки.

А другую галочку можно убрать. Читать историю развития программы на английском, думаю, вряд ли кому-то будет интересно. Жмем Finish:

Копируем сайт

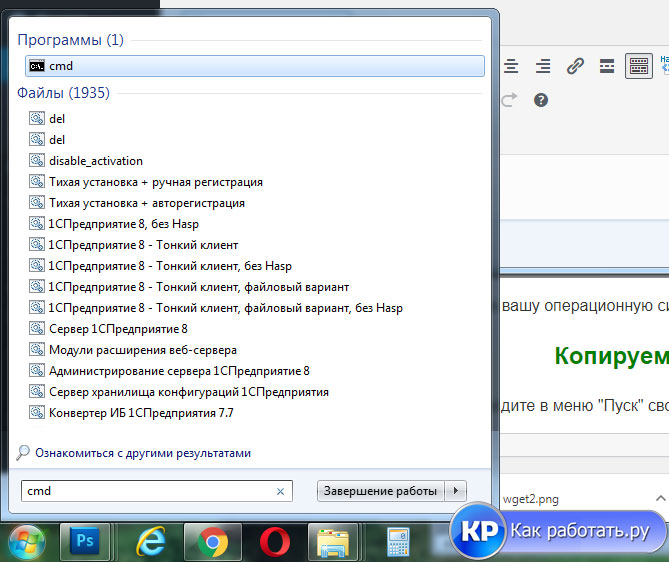

После того, как вы нашли сайт донор,зайдите в меню “Пуск” своего ПК и в строке поиска напишите cmd.

У вас откроется командная строка Windows. В командной строке пропишите http://sitedonor.ru/, где:

- http://sitedonor.ru/ – ссылка на сайт который необходимо скачать;

- -r — указывает на то, что нужно поочередно заходить по ссылкам на сайте и скачивать страницы;

- -k — используется для того, чтобы wget преобразовал все ссылки в скаченных файлах таким образом, чтобы по ним можно было переходить на локальном компьютере (в автономном режиме);

- -p — указывает на то, что нужно загрузить все файлы, которые требуются для отображения страниц (изображения, css и т.д.);

- -l — определяет максимальную глубину вложенности страниц, которые wget должен скачать (по умолчанию значение равно 5, в примере мы установили 10). В большинстве случаев сайты имеют страницы с большой степенью вложенности и wget может просто «закопаться», скачивая новые страницы. Чтобы этого не произошло можно использовать этот параметр;

- -E — добавлять к загруженным файлам расширение .html;

- -nc — при использовании данного параметра существующие файлы не будут перезаписаны. Это удобно, когда нужно продолжить загрузку сайта, прерванную в прошлый раз.

Нажимайте “Enter” – сайт уже скачивается.

Как только процесс завершится, обычно копирование Лендинга занимает не более минуты, найдите архив в следующей папке, по адресу C:/Users/имя пользователя пк, у меня это Эльдар.

Если вы все сделали правильно и сайт не защищен от копирования, то вы найдете папку под названием доменного имени донора, откройте ее и познакомьтесь с вложениями. Сайт полностью готов к работе, открыв файл Index.html вы в локальной версии можете посмотреть его, после внесения необходимых правок, перенесите все файлы на ваш хостинг, например через Filezilla и проверьте.

Иногда бывает, что файлы стилей или скриптов на исходном сайте имеют версии, тогда программа Wget при скачивании дописывает к файлам версию и при просмотре сайта на компьютере в локальной версии, они не будут работать, так как ПК не распознает такие расширения, для этого проверьте все папки со стилями и скриптами и если увидите например:

wb.rotate.js@v=6

jquery-1.11.3.js@v=2

То просто удалите символы после расширения файла *.js, а именно @v=цифра версии, т. е. у вас должно получиться:

wb.rotate.js

jquery-1.11.3.js

и все будет работать.

Обзор методов копирования

Мы рассмотрим методы, и постараемся описать преимущества и недостатки. На сегодняшний день существует два основных метода копирования сайтов: ручной

автоматизированный.

Ручной метод

С ручным все понятно. Это когда через браузер в один клик сохраняете страницу, либо в ручную создаете все файлы страницы: html файл с исходным кодом верстки, js, css, картинки и т.д. Так себя мучать мы Вам не рекомендуем.

Загружаем html код страницы

Далее всё очень просто: находим интересующий нас проект, открываем главную страницу и нажимаем на клавиши ctrl + U. Браузер сразу же показывает нам её код.

Копируем его, создаём новый файл в редакторе кода, вставляем код главной страницы, в новый файл, сохраняя его под названием index, с расширением html (index.html). Всё, главная страница сайта готова. Размещаем её в корне документа, то есть кладём файл индекс.html рядом с папками images, css и js

Далее чтобы скачать сайт целиком на компьютер проделываем тоже со всеми страницами сайта. (Данный метод подходит, только если ресурс имеет не слишком много страниц). Таким же образом, копируем все html-страницы понравившегося нам сайта в корневую папку, сохраняем их с расширением html и называем каждую из них соответствующим образом (не русскими буквами – contact.html, about.html).

Создаём css и js файлы

После того как мы сделали все страницы сайта, находим и копируем все его css стили и java скрипты. Для этого кликаем по ссылкам, ведущим на css и js файлы в коде.

Таким же образом как мы копировали файлы html, копируем все стили и скрипты создавая в редакторе Notepad++ соответствующие файлы. Делать их можно с такими же названиями, сохраняя их в папках сss и js. Файлы стилей кладём в папку css, а код java script в папку js.

Копируем картинки сайта

Чтобы скачать сайт целиком на компьютер также нам нужны все его картинки. Их можно загрузить, находя в коде сайта и открывая по порядку одну за другой. Ещё можно увидеть все картинки сайта, открыв инструменты разработчика в браузере с помощью клавиши F12. Находим там директорию Sources и ищем в ней папку img или images В них мы увидим все картинки и фотографии сайта. Скачиваем их все, ложа в папку images.

Убираем всё лишнее в html коде

После того как мы скачали все файлы сайта нужно почистить его код от всего лишнего. Например, можно удалить:

- код google analytics и yandex метрики;

- код верификации сайта в панелях для веб мастеров яндекса и гугла:

- можно удалить любой код, который нам не нужен и оставить тот, что нужен.

Автоматизированный

Рассмотрим наименее затратный способ — автоматизированный. К нему относятся онлайн сервисы (грабберы) для парсинга, и специальные десктопные программы. Чтобы Вам легче было выбрать, ниж рассмотрим более детально.

Преимущество онлайн сервисов заключается в том, что Вы получаете готовый результат, и не о чем не беспокоитесь. Ко всему прочему, Вы всегда можете спросить за результат. В редких случаях имеется возможность внесения правок в исходный код и дизайн силами исполнителя. К сожалению, данное удовольствие стоит денег, а потому для многих данный способ не приемлим.

Для тех, кто хочет сэкономить, на помощь приходят специальные программы для парсинга. Метод довольно затратный, если Вам нужно получить два-три сайта, т.к. каждая отдельная программа обладает своими особенностями, и для изучения Вам понадобится не мало времени.

А учитывая, что результат работы трудно редактируемый, то возникает вопрос: стоит ли тратить время на изучение, чтобы получить результат на который надо потратить еще кучу времени. Выбор за Вами.